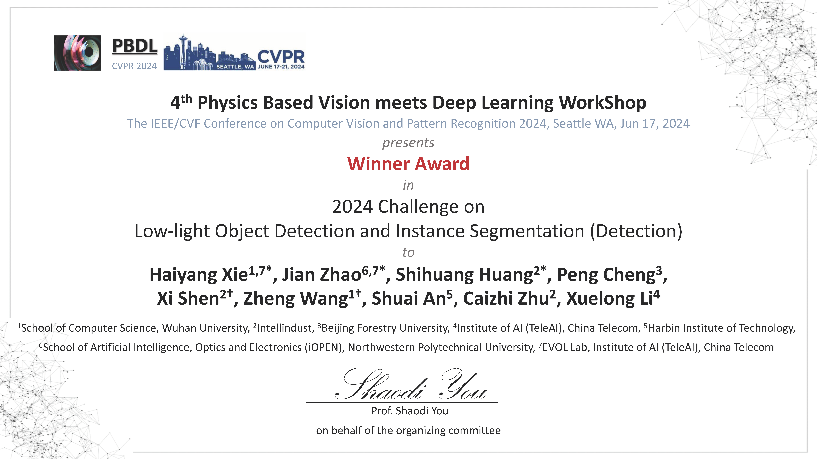

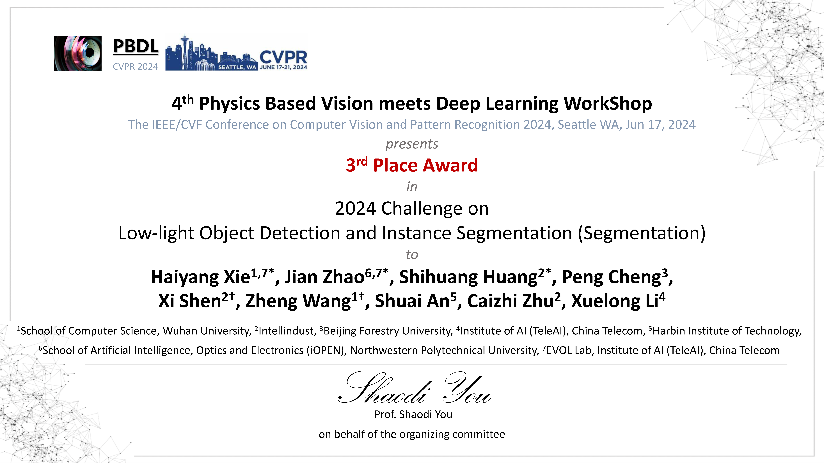

中心团队在CVPR2024竞赛中斩获佳绩

近日,武汉大学国家多媒体软件工程技术研究中心团队在CVPR2024的Low-light Object Detection and Instance Segmentation Challenge中获得了优异成绩,夺得了Detection Track的冠军和Segmentation Track的季军。该竞赛每个赛道均吸引了超过90支参赛队伍参加,参赛企业/高校还包括清华大学、联想、三星(samsung)、中国科学技术大学、澳大利亚国立大学(Australian National University)、英国布里斯托大学(University of Bristol)等。团队指导老师为王正教授,队长为计算机学院2023级硕士生谢海洋。

目标检测和实例分割是两个计算机视觉任务,对于自动驾驶和智能安防等领域具有重要意义。本次比赛聚焦于低光照及高噪声这样的更贴近真实应用场景的成像环境,旨在提升现有模型在真实世界中的应用能力。参赛模型需要以低光照和高噪声图像作为输入,要求模型输出图片物体类别、边界框以及像素级的掩码。团队提出”学的多+看的准”两步策略来应对这一挑战。

首先,丰富的高质量训练数据对于模型性能至关重要,而采集低光照数据集费时费力且繁琐。于是,为了让模型“学的多”,团队将目光转向现有的正常的RGB数据集COCO数据集,利用ISP逆处理将其转变为与比赛数据集分布相似的数据。而后将逆处理后的数据集用于模型的预训练。从而让模型在尽可能多的数据上进行学习,强化模型的提取语义特征能力和泛化能力。

其次,为了让模型“看的准”,团队在算法中引用一种投票机制来获得更加准确的检测效果。在Co-Detr、DINO、RTMDet和YOLO-X等领先的目标检测模型的基础上,通过设定不同的随机种子、使用不同参数量的模型和使用额外数据集等方式获得18个模型,然后采用了加权边界框融合技术(Weighted Box Fusion),综合考虑各个模型的置信度和准确性,得到更精确的目标检测结果。对于Instance Segmentation Track,团队在RTMDet-X模型的基础上,针对非极大值抑制(NMS)逻辑进行了优化,使得模型输出更多高质量的候选提案,显著提高了模型的分割精度。

扫一扫关注微信公众号

扫一扫关注微信公众号